Technológia umelej inteligencie (AI) napreduje tak rýchlo, že vedci z prestížnych univerzít a spoločností ako OpenAI a Microsoft tvrdia, že potrebujeme lepší spôsob, ako overiť, či je osoba na internete skutočne človek, a nie AI bot. Vo svojej novej štúdii, ktorá ešte neprešla recenzným procesom, navrhujú zavedenie systému „osobnostného preukazu“ (PHC) na overenie ľudskosti, ktorý by nahradil súčasné metódy ako CAPTCHA.

Pre tých, ktorí sa obávajú ochrany súkromia a masového sledovania, je však tento návrh problematický, pretože zodpovednosť za bezpečnosť presúva na bežných používateľov. Tento prístup je často kritizovaný, pretože technologické spoločnosti týmto spôsobom odľahčujú svoje vlastné bremeno a prenášajú ho na užívateľov, čo je v Silicon Valley bežná prax.

„Občiansky preukaz“ pre využitie na internete

Výskumníci zdôrazňujú, že PHC je reakciou na riziká, ktoré prináša masové nasadenie AI, schopnej vierohodne napodobňovať ľudské správanie a vytvárať obsah, ktorý vyzerá ako výsledok ľudskej činnosti. Podľa nich by PHC mohol byť účinným nástrojom proti „škodlivým aktérom“, ktorí by mohli využiť AI na zaplavenie internetu obsahom, ktorý síce vyzerá autenticky, no v skutočnosti je generovaný strojmi.

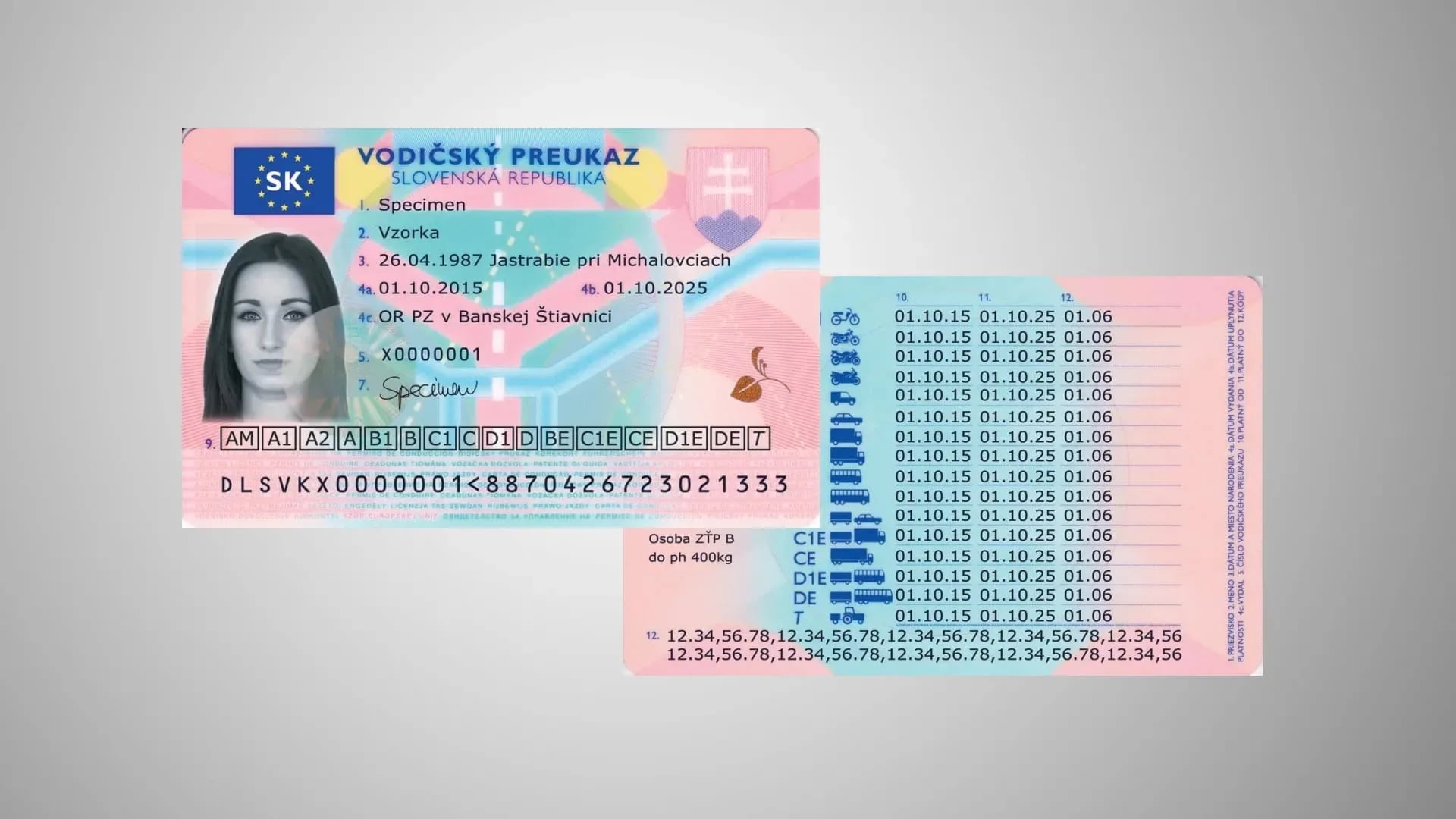

PHC by fungoval tak, že každému používateľovi digitálnych služieb, napríklad od vlády, by bol pridelený unikátny preukaz potvrdzujúci jeho ľudskosť. Tento preukaz by bol overený pomocou kryptografickej techniky nazývanej zero-knowledge proofs, čo umožňuje overenie bez odhalenia konkrétnych dát. Užívateľ by svoj preukaz uchovával digitálne na svojom zariadení, čo by zároveň malo zachovať jeho anonymitu na internete.

Náchylný na útoky hackerov

Napriek tomu, že tento systém sa zdá byť efektívnym riešením na papieri, výskumníci pripúšťajú, že má aj svoje úskalia. Jedným z najväčších rizík je, že niektorí ľudia by mohli svoj PHC predať spammerom, čím by poskytli automatizovanému obsahu zdanie dôveryhodnosti a tým podkopali celý účel projektu.

Okrem toho hrozí, že organizácie vydávajúce tieto preukazy by získali príliš veľkú moc, čo by mohlo viesť k zneužitiu systému. Systém by bol tiež náchylný na útoky hackerov, čo zvyšuje riziko narušenia jeho bezpečnosti.

Ďalším problémom je, že menej technicky zdatní užívatelia, ako sú napríklad starší ľudia, by mohli mať ťažkosti s používaním tohto systému, čo by ich ešte viac vystavilo riziku podvodov. Preto výskumníci navrhujú, aby vlády najprv vyskúšali PHC prostredníctvom pilotného programu.

Napriek tomu sa týmto riešením obchádza podstatná otázka: prečo by mali byť za tento problém zodpovední bežní používatelia, keď sú to práve technologické spoločnosti, ktoré tento problém vyvolali? Firmy, ktoré vyvíjajú a zavádzajú AI, by mali byť tie, ktoré nesú zodpovednosť za jeho bezpečné používanie.

AI je nutné označovať

Jedným z krokov, ktoré by mohli podniknúť, je zavedenie vodotlačí na obsah generovaný AI alebo vývoj systémov na rozpoznávanie znakov, ktoré naznačujú, že určitý obsah bol vytvorený AI. Hoci ani jedno z týchto riešení nie je bez chýb, aspoň by preniesli zodpovednosť tam, kam patrí – na tvorcov technológií.

Ak sa technologické spoločnosti úplne vyhnú tejto zodpovednosti, bude to len ďalší čierny bod pre Silicon Valley, ktoré je známe tým, že prináša problémy, ktoré nikto nežiadal, zatiaľ čo zarába na ich dôsledkoch.

Rovnako ako technologické spoločnosti spotrebúvajú obrovské množstvá elektriny a vody na prevádzku dátových centier AI, pričom komunity – najmä v oblastiach postihnutých suchom – trpia v dôsledku tohto rozdelenia zdrojov, PHC môže byť atraktívne riešenie na papieri, no opäť len presúva bremeno na používateľov.